La Inteligencia Artificial y la Singularidad parte IV

En la anterior publicación analizamos el concepto de Singularidad Tecnológica, el momento en el que el avance tecnológico se acelera tanto que se hace irreversible e incontrolable al alcanzarse una Inteligencia Súper Humana y producirse una Explosión de Inteligencia. Exploramos los factores que aceleran el avance en la Inteligencia Artificial (AI) y discutimos si esta Singularidad es un hecho inevitable. En esta publicación analizaremos las plausibilidad y las implicaciones de la Singularidad, de acuerdo a los futurólogos más importantes que la han analizado.

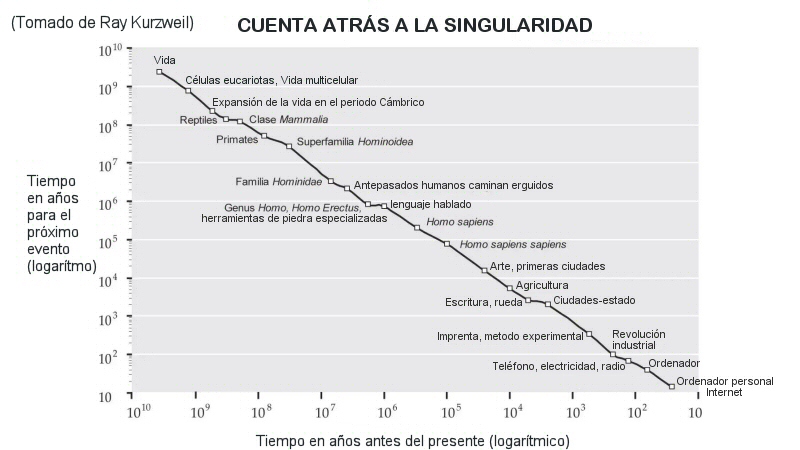

La observación constatada de que aproximadamente cada 2 años se duplica el número de transistores que se pueden montar en un microprocesador de igual tamaño, que fue sugerido por la Ley de Moore, se cita habitualmente como una razón para esperar una singularidad en un futuro relativamente cercano. Ray Kurzweil postula una Ley de rendimientos acelerados, en la que la velocidad del cambio tecnológico aumenta exponencialmente, generalizando la ley de Moore. Predice que los hitos y cambios de paradigma serán cada vez más frecuentes, dando lugar a "un cambio tecnológico tan rápido y profundo que representa una ruptura en el tejido de la historia humana". Algunos críticos, como el filósofo Hubert Dreyfus, afirman que los ordenadores o las máquinas no pueden alcanzar la inteligencia humana, mientras que otros, como el físico Stephen Hawking, sostienen que la definición de inteligencia es irrelevante si el resultado neto es el mismo.

El investigador y empresario Paul Allen argumentó que hay un freno en la complejidad; cuanto más avanza la ciencia hacia la comprensión de la inteligencia, más difícil resulta realizar progresos adicionales. El físico y futurólogo Theodore Modis en un artículo de 2021 señalaba que en los veinte años anteriores no se había observado ningún hito comparable en importancia al uso de Internet, el descubrimiento del genoma humano, el transistor o la energía nuclear, mientras que no habrían ocurrido los cinco hitos esperados según la tendencia exponencial propugnada por los defensores de la Singularidad.

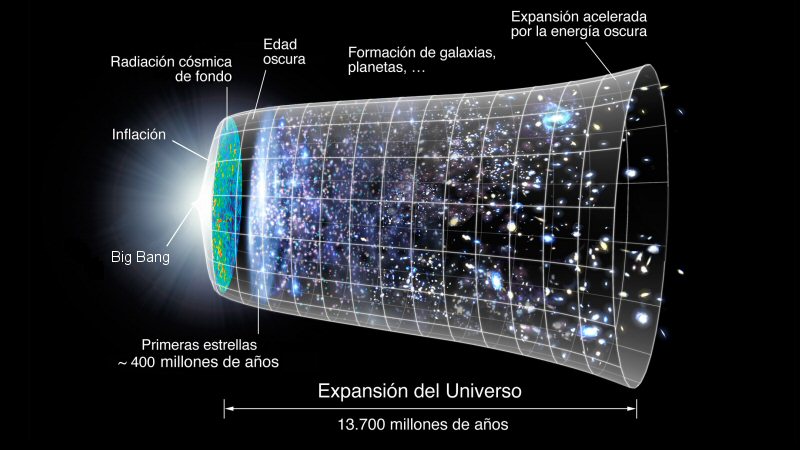

Robin Hanson publico un ensayo sobre el crecimiento como una secuencia de etapas exponenciales. En él se recoge cómo la economía se duplicó cada 250.000 años desde el Paleolítico hasta la Revolución Neolítica. La nueva economía agrícola se duplicaba cada 900 años. Con la Revolución Industrial, la producción económica mundial se duplica cada quince años. Si el auge de la inteligencia sobrehumana provoca una revolución similar, argumenta Robin Hanson, cabría esperar que la economía se duplicara al menos trimestralmente y posiblemente semanalmente. Un artículo publicado en 2016 en Trends in Ecology & Evolution sostiene que, desde la perspectiva de la evolución, varias transiciones mayores en la evolución anteriores han transformado la vida mediante innovaciones en el almacenamiento y la replicación de la información (ARN, ADN, multicelularidad, cultura y lenguaje). En la etapa actual de la evolución de la vida, la biosfera basada en el carbono ha generado un sistema cognitivo (los humanos) capaz de crear tecnología que dará lugar a una transición evolutiva comparable.

Una de las figuras más citadas al hablar de la Singularidad es Ray Kurzweil. Este investigador ha postulado que el crecimiento exponencial continuará y que, en unas pocas décadas, la potencia de cálculo de todos los ordenadores superará a la suma de los cerebros humanos "no mejorados", y que la inteligencia artificial sobrehumana aparecerá alrededor de 2045. También predice que la Singularidad nos permitirá trascender las limitaciones de nuestros cuerpos y cerebros biológicos y que después de la Singularidad, no habrá distinción entre humanos y máquinas. Algunos futurólogos sugieren que los humanos se conectarán directamente con ordenadores o cargarán sus mentes en ordenadores.

El Transhumanismo es un movimiento filosófico e intelectual que aboga por la mejora de la condición humana mediante el desarrollo y la generalización de tecnologías sofisticadas que puedan aumentar considerablemente la longevidad y la cognición. Los pensadores transhumanistas estudian los beneficios y peligros potenciales de las tecnologías emergentes que podrían superar las limitaciones humanas fundamentales, así como la ética del uso de dichas tecnologías. Algunos transhumanistas creen que los seres humanos podrían llegar a transformarse en seres con capacidades tan superiores a las actuales que merecerían la etiqueta de seres posthumanos.

Anthony Berglas afirma que no existe una motivación evolutiva directa para que una AI sea amistosa con los humanos. La evolución no tiene una tendencia inherente a producir resultados valorados positivamente por los humanos, y hay pocas razones para esperar que un proceso de optimización arbitrario promueva un resultado deseado por la humanidad. El físico Stephen Hawking dijo en 2014 que "el éxito en la creación de una AI sería el mayor acontecimiento de la historia de la humanidad. Por desgracia, también podría ser el último, a menos que aprendamos a evitar los riesgos." Debido a que la AI es un factor importante en el riesgo de una singularidad descontrolada, varias organizaciones persiguen una teoría técnica para alinear los sistemas de objetivos de la AI con los valores humanos, incluyendo el Future of Humanity Institute, el Machine Intelligence Research Institute, el Center for Human-Compatible Artificial Intelligence, y el Future of Life Institute.