La Inteligencia Artificial y la Singularidad parte III

En la anterior publicación propusimos un método para que las propias máquinas ayuden a desarrollar sistemas de Inteligencia Artificial (AI) cada vez más complejos y completos hasta llegar a conseguir una Inteligencia Artificial General. También debatimos si estas máquinas tendrían o no consciencia. En esta publicación exploraremos lo que se ha denominado Singularidad Tecnológica y si es inevitable tras alcanzar la Inteligencia Artificial General.

Una faceta de la Inteligencia Artificial General que asusta a muchos es que las propias máquinas puedan tomar el control de su desarrollo de forma autónoma y escapen absolutamente de nuestra vigilancia. Muchos emplean el término Singularidad Tecnológica como el momento en el que el avance tecnológico se acelere tanto que se haga irreversible e incontrolable. En la versión más habitual, la Singularidad se origina debido a un agente inteligente artificial que se actualiza y que entra en una reacción en cadena de ciclos de auto mejora, tanto en su software como en su hardware, dando origen a una súper inteligencia que sobrepasa a la inteligencia humana y a unos saltos cualitativos técnicos enormes que no sabremos ya comprender. Científicos como Stephen Hawking han expresado su preocupación por la posibilidad de que la superinteligencia artificial provoque la extinción humana. Otros creen que en estos procesos, el ser humano evolucionará o modificará directamente su biología para alcanzar una inteligencia radicalmente superior.

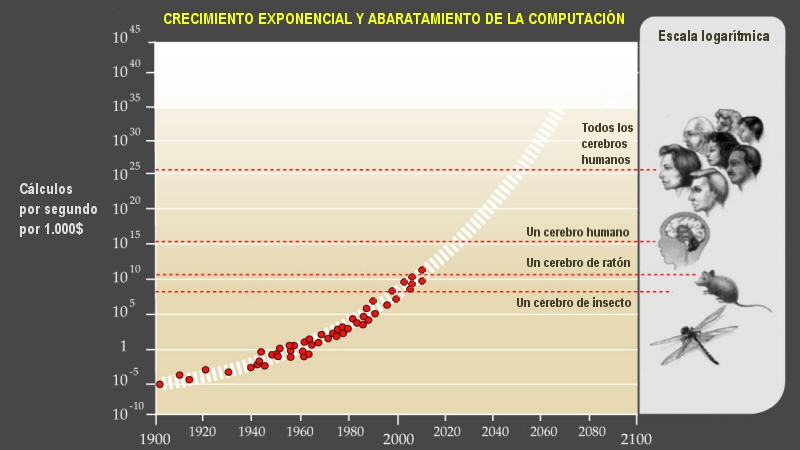

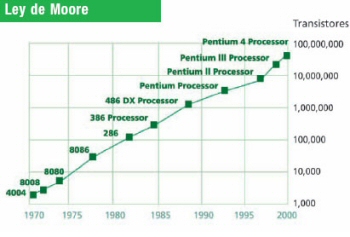

Hay varios factores que facilitan las mejoras en AI: La primera es la ley de Moore, que es la observación constatada de que aproximadamente cada 2 años se duplica el número de transistores que se pueden montar en un microprocesador de igual tamaño. La segunda es el aumento en la velocidad y el abaratamiento de la computación. Este aumento se evidencia desde el primer ordenador electromecánico, el Z3 de 1938 a 5 Hertzios (Hz), pasando por el primer ordenador digital, el ENIAC de 1945 a 100kHz, hasta llegar al AMD FX-8350 de 2012 a 8,79 GHz. Por último, la paulatina mejora de los algoritmos usados para emplearlos en la AI. Algunas tecnologías de inteligencia artificial también podrían modificar estos algoritmos, no sólo ser para más rápidos, sino también más eficientes. Cuatro encuestas a investigadores en IA, realizadas en 2012 y 2013 por Nick Bostrom y Vincent C. Müller, sugerían una confianza del 50% en que la Inteligencia Artificial General se desarrollaría entre 2040-2050.

Con la creciente potencia de los ordenadores y las tecnologías descritas, podría llegar a ser posible construir una máquina mucho más inteligente que los humanos. Si se creara una IA con capacidades de ingeniería que igualaran o superaran las de sus creadores humanos, tendría el potencial de mejorar de forma autónoma su propio software y hardware para diseñar una máquina aún más capaz, que podría repetir el proceso a su vez. Esta mejora recursiva podría acelerarse y permitir enormes cambios cualitativos, dando lugar a la Inteligencia sobrehumana y a la llamada Explosión de inteligencia. En una encuesta realizada en 2017 en las conferencias de aprendizaje automático NeurIPS e ICML de 2015, se preguntó sobre la probabilidad de que se produjera una explosión de inteligencia. De los encuestados, el 12% dijo que era "bastante probable", el 17% dijo que era "probable", el 21% dijo que era "más o menos probable", el 24% dijo que era "poco probable" y el 26% dijo que era "bastante poco probable"

En la siguiente publicación hablaremos de las implicaciones de la Singularidad Tecnológica de acuerdo a los futurólogos más importantes que la han analizado.